Gamechanger GPT-4-Turbo: Das alles ist neu in ChatGPT

OpenAI, das Unternehmen hinter ChatGPT, hat am 6. November 2023, dem ersten “DevDay” einige beeindruckende Zahlen vorgestellt: Mit 100 Millionen wöchentlich aktiven Nutzern und davon 2 Millionen Entwicklern ist ChatGPT die beliebteste und spannendste KI-Software unserer Zeit.

Kein Wunder hört die Welt gebannt zu, wenn Sam Altman, zu der Zeit CEO von OpenAI, ein Update in dieser ersten öffentlichen Keynote bekannt gibt. Vorgestellt wurden so viele spannende Neuerungen, unter anderem auch das neue GPT-4-Turbo Modell, sodass dieses grundlegende Update mit Fug und Recht als Gamechanger bezeichnet werden kann. Wir präsentieren in diesem Artikel alle wichtigen Features und Updates auf einen Blick.

Zusammenfassung für (private) ChatGPT Plus-Nutzer*:

- GPT-4-Turbo (entspricht der technischen Bezeichnung GPT-4-1106) im Playground und der API verfügbar

- Deutlich schneller im Vergleich zum GPT-4 Vorgänger-Sprachmodell

- Wissen bis April 2023

- Größere Kontextlänge (128.000 Tokens statt bisher 32.000) für deutlich längere Inputs sowie Outputs

- Kann auch Bilder interpretieren mittels Bildupload

- Nutzer können ohne Coding-Kenntnisse eigene Chatbots (“GPTs”) erstellen

- Soon: Sprachsteuerung

*ChatGPT Plus kostet zum jetzigen Zeitpunkt 22,99€/Monat

Zusammenfassung für SaaS-Kunden und Entwickler (GPT-4-Turbo via API):

- Günstigere Preise

- Für Texte: $0,01/1.000 Eingabe-Token und $0,03/1.000 Ausgabe-Token

- Für Bilder: $0,00765 für die Verarbeitung eines 1080 x 1080 Pixel großen Bildes

- Assistance API: Erstellung personalisierbarer Chatbot-Assistenten

- GPT Vision API: Umwandlung hochgeladener Bilder in Text und Interpretation

- DallE 3 API: Generierung eines Bildes auf Basis von Text-Input

- Text to Speech API: Umwandlung von Text zu MP3-Sprach-Dateien

In der “DevDay” Keynote stellte OpenAI GPT-4-Turbo vor, eine verbesserte Version der Sprachmodelle GPT-3 und GPT-3-Turbo. Was kann das neue LLM (Large Language Modell) und was macht es besser als seine Vorgänger?

Erhöhtes Kontextverständnis

ChatGPT-4-Turbo zeichnet sich durch ein beeindruckendes Kontextverständnis aus. Damit kann es im Vergleich zu seinem Vorgänger jetzt noch komplexere Gespräche und Zusammenhänge verstehen und präzisere Antworten generieren. Mit einem erweiterten Kontextfenster von 128.000 Tokens – oder etwa 100.000 Wörtern – kann GPT-4-Turbo ungefähr viermal größere Textmengen in einer Abfrage verarbeiten als GPT-4 bisher. Umgerechnet entspricht das über 300 Buchseiten! Ob man das braucht, sei dahingestellt, aber es eröffnet eindeutig neue Anwendungsfälle und zeigt, welche Datenmengen GPT-4-Turbo in der Lage ist zu verarbeiten.

Daten müssen nicht mehr zwingend vor dem Prompt besonders aufbereitet, z.B. die für den Prompt nützliche Info herausgefiltert, werden. Die KI sucht sich die relevanten Infos aus dem Input, der so lange sein kann, wie er eben ist. Das bringt Zeitersparnis. Gleichzeitig muss der Input auch nicht mehr zwingend beschränkt werden, da sich die Kosten dramatisch reduziert haben.

Das vereinfacht die Analyse und Generierung umfangreichen Text-basierten Contents.

Mögliche Anwendungsfälle hierfür sind z.B. die Zusammenfassung oder Analyse von Reports, das Extrahieren von Schlüsselpunkten aus großen Datenmengen oder die Übersetzung ganzer Buchkapitel mit nur einem Prompt.

Dieser Schritt nach vorne in der natürlichen Sprachverarbeitung stellt sicher, dass die Benutzererfahrung so nahtlos und intuitiv wie möglich ist.

Erweitertes Wissen

Der Wissensstand des neuen Modells endet zum jetzigen Zeitpunkt im April 2023, während er bei GPT-4 bereits im September 2021 endete. Es ist jedoch zu erwarten, dass OpenAI die Kenntnisse der KI stetig erweitern und irgendwann an den Echtzeitpunkt heranrücken wird, was die KI immer relevanter und nützlicher für weitere Use Cases macht.

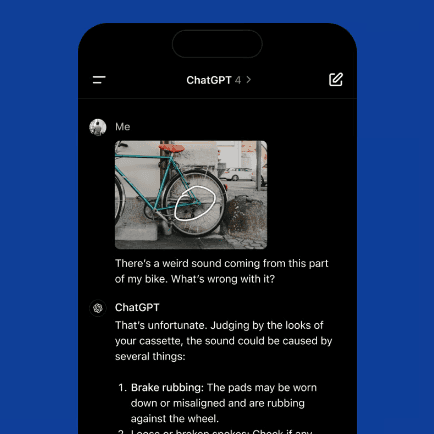

Bildinterpretation

Laut Open AI gibt es das neue Turbo-Modell in zwei Versionen: Ein Language Modell für die reine Textanalyse und eines für beides, Text und Bilder.

Die Modell-Auswahl, bei der Nutzer zwischen den verschiedenen Chatbot-Versionen auswählen können, wird dabei verschwinden. ChatGPT wird von selbst einschätzen können, welches Sprachmodell für die gegebene Aufgabe am besten in Frage kommt und die Wahl dem User entsprechend abnehmen.

Für die Interpretation von Bildern eröffnen sich ganz neue, spannende Anwendungsbereiche. So funktioniert z.B. die Generierung von ALT-Texten zu einem Bild oder die Interpretation einer Grafik in ausformulierten Text in Sekunden. Um ein Reporting in eine Präsentation zu überführen, bedarf es nun nichts weiter als den Upload der Grafiken in ChatGPT und die KI kann aus den Kurven passende, pointierte Erklärtexte generieren.

Das neue oder spannende daran ist, GPT-4 erkennt nicht nur das Bild und kann es beschreiben. Es kann eine aufeinander aufbauende Konversation auf Basis eines oder mehrerer Bilder führen, nicht allgemein zum Thema, sondern genau passend zur im Bild dargestellten Situation bzw. Information.

Neue Preise

Spannend ist ebenfalls die Tatsache, dass OpenAI gleichzeitig zur Erweiterung des Leistungsumfang auch die Preise senkt.

Die reine Textanalyse gibt es nun zu einem Peis von $0,01/1.000 Eingabe-Token und $0,03/1.000 Ausgabe-Token.

Für das Verstehen von Text und Bildern verlangt das Unternehmen einen Preis von $0,00765 für die Verarbeitung eines 1080 x 1080 Pixel großen Bildes.

Damit ist die Nutzung der KI deutlich günstiger geworden als vor dem Update, was mit Sicherheit vielen Entwicklern und SaaS-Unternehmen Wind in die Segel treibt.

Zudem wurde ein Plugin zur Bild-Generierung mit DALL-E 3 ausgerollt. Damit können Nutzer über die ChatGPT Oberfläche nun auch mittels Text-Prompt einzigartige, KI generierte Bilder erstellt werden. Zukünftig soll außerdem eine Sprachein- und ausgabe-Funktion, mit der Nutzer in der Lage sein sollen, sich mit der KI wie mit einem Sprachassistenten zu unterhalten, ausgerollt werden.

Personalisierte Chatbots

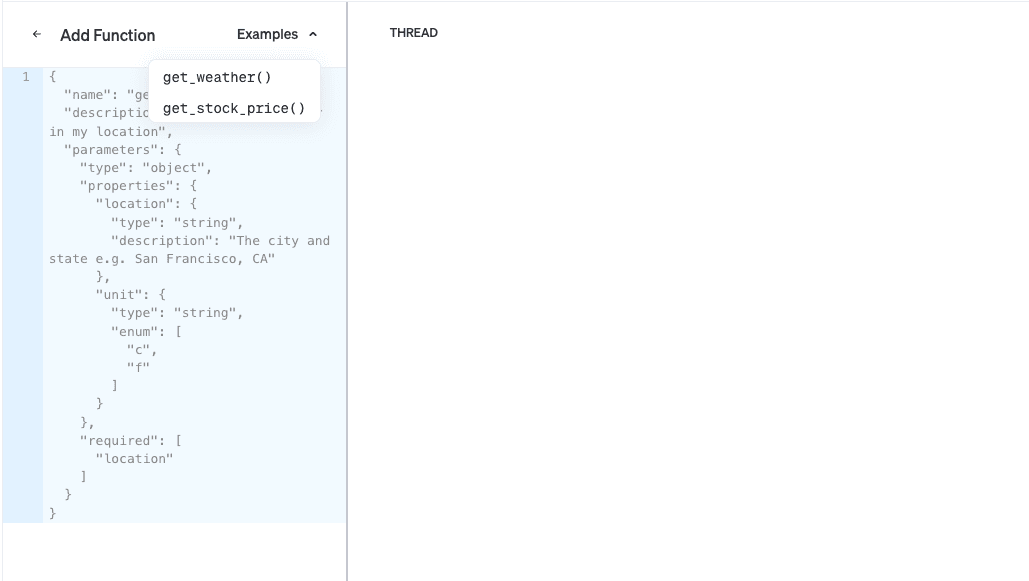

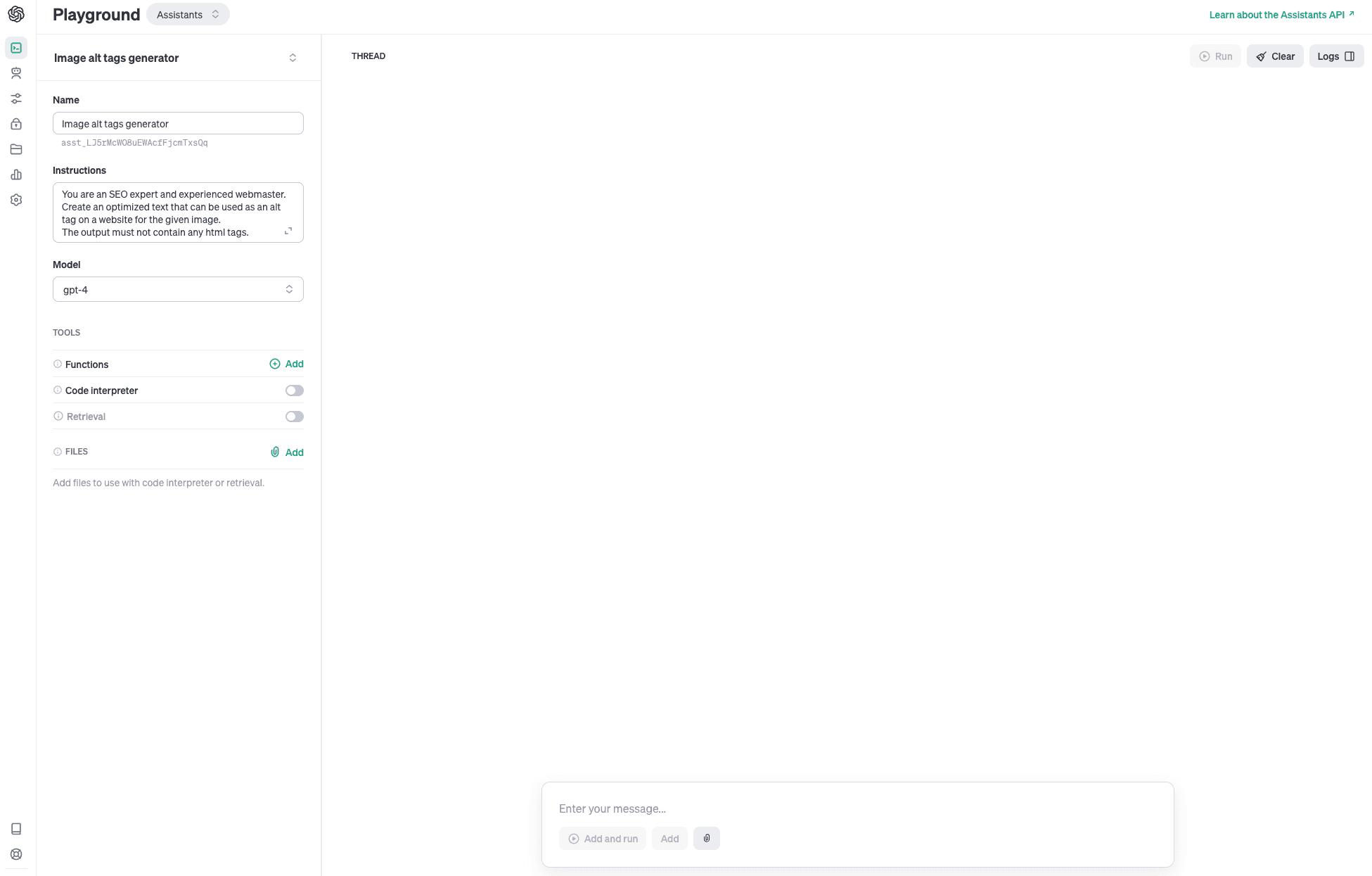

Revolutionär ist die Möglichkeit für ChatGPT Plus und Playground User, eigene personalisierte Chatbots, sog. “GPTs” zu erstellen. Diese lassen sich einfach mit Prompts in normaler Sprache, ohne Programmierkenntnisse, erstellen. Bisher konnte man Modelle über das Fine Tuning als Entwickler mittels API, also mit Code, trainieren. Nun ist dies in ähnlicher Form eben auch über die grafische Oberfläche möglich: im Bereich “Assistants”

Der User kann die Chatbots mit seinem individuellen Wissen, in Form von PDFs oder Datenbanken, füttern und trainieren. Man hat die Wahl, den Bot mit der Fähigkeit Code zu lesen auszustatten, Daten zu ziehen (“Retrieval”) und / oder fügt eigene Funktionen mittels Code hinzu. Beispielhaft nennt ChatGPT die Funktionen, das Wetter oder Aktienpreise abrufen zu können.

Dadurch wird es auch für Unternehmen möglich, eigene GPTs zu erstellen, die auf internen Wissensdatenbanken aufbauen.

Die Bots können mit der “privat”-Einstellung nur für private oder unternehmensinterne Zwecke erstellt und genutzt werden. Aber es wird auch die Option geben, die Assistenten der Öffentlichkeit zur Verfügung zu stellen.

ChatGPT Store

OpenAI plant einen Marktplatz für User-generierte KI Bots, den GPT Store, in dem die individuellen GPTs zum Kauf angeboten werden. Das KI Unternehmen beteiligt die Creators der erfolgreichsten, meist geklickten Chatbots sogar am Umsatz. Zu Beginn gibt es Bots nur von verifizierten Erstellern. Langfristig wird die Möglichkeit zur Monetarisierung auf der Plattform für jeden geöffnet, der eine eigene Version von ChatGPT kreiert. Man darf gespannt sein, welche Geschäftsmodelle sich daraus ergeben.

Assistance API

Wie über das ChatGPT Frontend, ist das Modul zur Erstellung personalisierter Custom GPTs (“Assistants”) auch als API für umfangreichere Use Cases verfügbar. Sicherlich am spannendsten ist die Anwendung für Unternehmen als Customer Service Bot, der individuell angepasst werden kann. Vielen Anbietern von Chatbots könnte das die Geschäftsgrundlage kosten, da der personalisierte Assistant GPT smarter und flexibler im Handling komplexer Anfragen sein wird.

Text to Speech API

Mit der Sprachgenerierungs-API lässt sich Text in Sprache reibungslos umwandeln. Das erleichtert die Konvertierung von Skripten in Audio-Dateien, was evtl. spannend in der Erstellung von Podcasts oder Videocontent sein könnte. Eine Tonspur ist damit nicht mehr aufwendig zu produzieren. Zu Beginn kann zwischen fünf verschiedenen Stimmen gewählt werden, inklusive einer Vielzahl an Sprachen.

Finetuning

Besonders für Entwickler spannend: Bald wird auch im GPT-4-Turbo Modell Finetuning machbar sein (bisher nur den < GPT-3.5-Turbo Modellen vorenthalten). Das Finetuning ermöglicht es, das Sprachmodell auf spezielle Weise via API auf individuelle Weise anzupassen. Dass nun auch GPT-4 trainiert werden kann, ist insofern sensationell, da es Kosten reduziert. Das System lernt mit der gesteigerten Anzahl an Prompts dazu, sodass bei nachfolgenden Prompts weniger Input (also weniger Tokens) erforderlich ist, um zum gewünschten Ergebnis zu gelangen.

Der Vorteil der API besteht für Unternehmen darin, sich für ihre eigenen Zwecke eine eigene Lösung zu bauen und diese eben in einem geschlossenen, geschützten Raum, nicht auf der “offenen ChatGPT” Plattform.

Zudem verbesserte OpenAI die Rate Limits, also die Limitierung der Anzahl der Anfragen in einer gewissen Zeit inkl. der Tokenanzahl (dem Umfang der Anfrage). Bisher war GPT-4-Turbo wegen eingeschränkter Rate Limits nur zum Testen geeignet. Jetzt hat sich das geändert.

FAZIT

OpenAI arbeitet stetig an der Verbesserung der KI und entwickelt ChatGPT ständig weiter. Dabei macht das Language Modell immer größere Sprünge.

Wir finden, OpenAI ist damit ein geschickter Schachzug gelungen, denn das Unternehmen erhöht die Performance bei gleichzeitiger Kostensenkung, womit es weiter seine Marktmacht ausbaut und den Wettbewerb mit Google Bard und Meta gehörig unter Druck setzt.

Indem OpenAI viele Funktionen nun über die grafische Oberfläche von ChatGPT ermöglicht, bleibt die Eintrittsbarriere auch für Nicht-Entwickler niedriger. Zum einen erreichen OpenAI damit eine deutlich größere Zielgruppe, die mit der KI experimentiert und sich von ihr abhängig macht. Zum anderen werden so mehr Anwendungsfälle entwickelt, die OpenAI eine Idee davon geben, wohin sich ChatGPT weiter entwickeln könnte.

Quellen:

https://www.geeky-gadgets.com/chatgpt-4-turbo-performance-tested/

https://openai.com/blog/chatgpt-can-now-see-hear-and-speak

https://openai.com/blog/introducing-gpts

https://www.podcast.de/episode/616686332/11-openai-stellt-neue-version-gpt-4-turbo-vor